L'évolution des priorités de performances et de qualité des cartes vidéo des années 2000 jusqu'à la mise à l'échelle

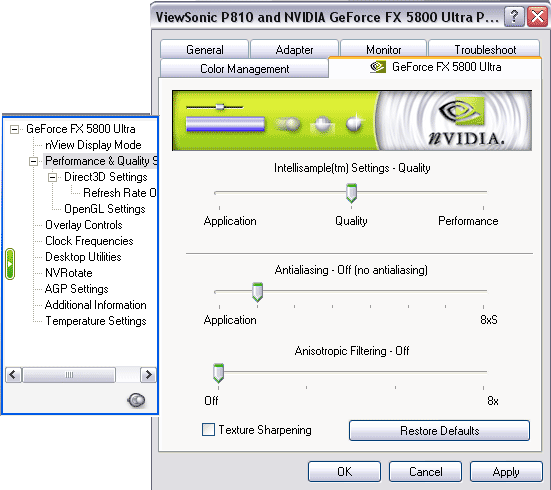

Au début des années 2000, l'industrie des cartes graphiques a été confrontée à plusieurs scandales liés à l'optimisation des pilotes pour améliorer les performances au détriment de la qualité graphique, provoquant un mécontentement généralisé parmi les consommateurs et les critiques. L'un des exemples les plus célèbres est le scandale des cartes vidéo NVIDIA, lorsqu'en 2003, la société a été accusée d'avoir spécialement optimisé les pilotes de la carte vidéo GeForce FX 5800 pour améliorer les résultats dans des tests synthétiques spécifiques tels que 3DMark. Cela a abouti à une amélioration des performances de référence, mais la qualité graphique réelle des jeux en a souffert, provoquant la frustration des utilisateurs.

Les conséquences de ce scandale furent importantes pour NVIDIA. Les consommateurs ont commencé à douter de leur confiance dans le fabricant, ce qui a temporairement réduit les ventes et détérioré la réputation de l'entreprise. Cela a également contribué à une surveillance plus stricte des méthodes de test et des normes de transparence dans l’ensemble du secteur. NVIDIA a dû repenser ses pratiques de développement de pilotes et promettre une plus grande ouverture dans ses pratiques d'ingénierie et de marketing.

Un autre exemple concerne ATI, qui a également fait l’objet de critiques similaires au cours de la même période. En particulier, la carte vidéo ATI Radeon 9700 Pro a montré des résultats exceptionnels dans les benchmarks grâce aux optimisations des pilotes, ce qui a soulevé des soupçons de concurrence déloyale. Cependant, contrairement à NVIDIA, ATI a pu regagner plus rapidement la confiance des consommateurs grâce à une communication plus ouverte sur ses méthodes d'optimisation et en se concentrant sur l'amélioration de la qualité globale de l'expérience utilisateur.

Les technologies de mise à l'échelle telles que le DLSS (Deep Learning Super Sampling) de NVIDIA et le FSR (FidelityFX Super Resolution) d'AMD sont activement mises en œuvre dans les jeux vidéo et les applications modernes pour améliorer les performances sur du matériel moins puissant. Ces technologies présentent cependant des inconvénients importants qu’il faut juger en fonction de la qualité de l’image originale.

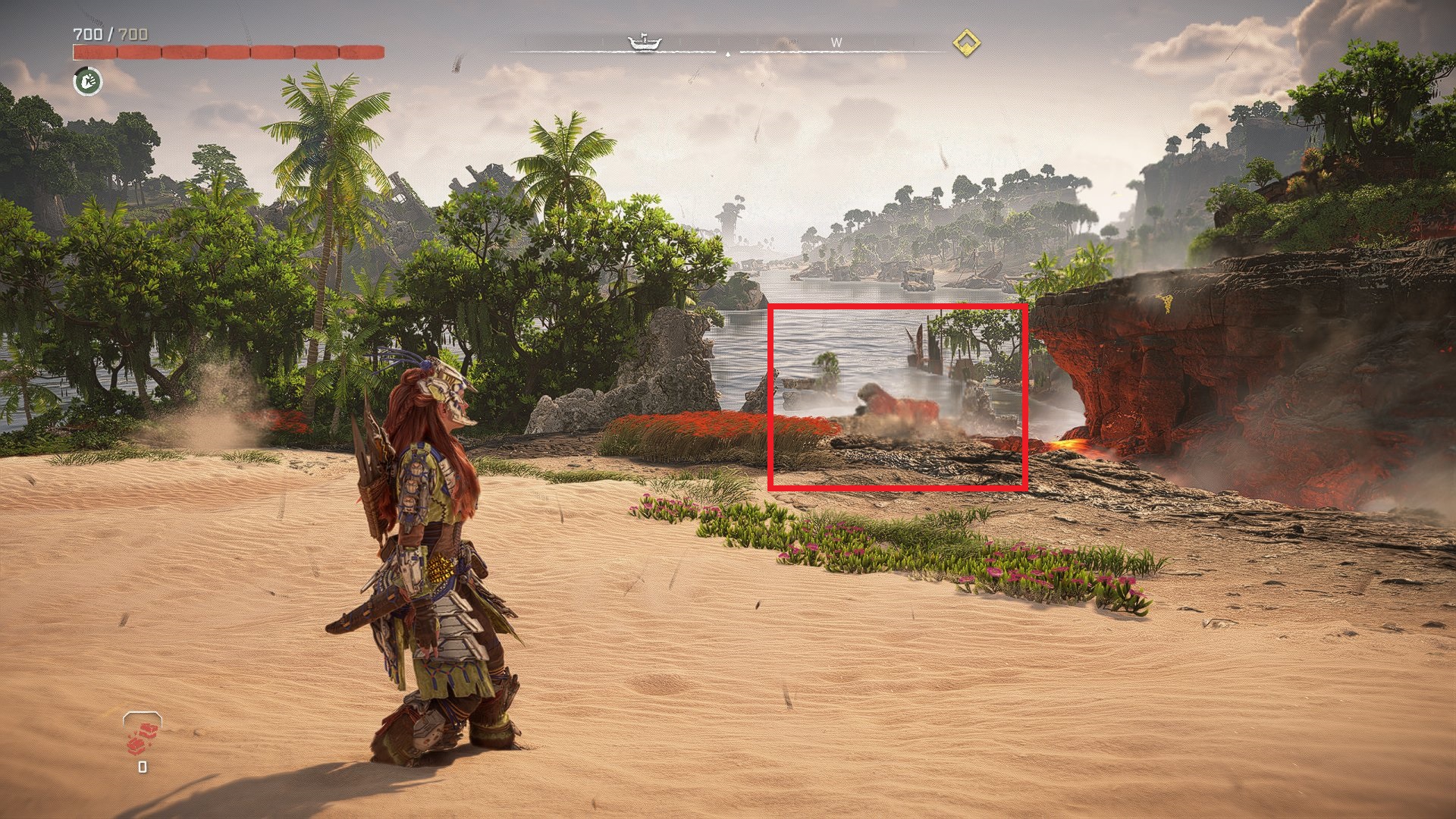

La mise à l'échelle entraîne souvent une dégradation de la qualité de l'image, en particulier en FSR, en introduisant divers types d'artefacts tels que le flou, la perte de détails et la distorsion visuelle. Ces effets sont particulièrement visibles lorsque l’on compare la mise à l’échelle à la haute résolution native, où cette dernière fournit des images nettement plus propres et plus détaillées. Utiliser la mise à l'échelle au lieu d'améliorer le matériel ou d'optimiser le code du jeu peut être perçu comme une tentative de masquer le manque de performances du matériel.

De plus, la mise à l’échelle peut induire les utilisateurs en erreur quant aux véritables performances d’une carte graphique. Les fabricants peuvent utiliser l'upscaling pour augmenter artificiellement les FPS dans les jeux, ce qui ne reflète pas les capacités réelles du matériel. Cela mine la confiance des consommateurs car l’amélioration réelle des performances ne correspond pas aux affirmations.

À la lumière de ces facteurs, la mise à l’échelle doit être considérée comme une solution temporaire et non comme un remplacement des améliorations techniques nécessaires ou du développement de logiciels plus efficaces. Les consommateurs devraient exiger plus de transparence de la part des fabricants concernant l'utilisation de la mise à l'échelle et son impact sur la qualité de l'image et les performances globales du système. A la sortie des jeux, en raison d'une optimisation insuffisante, les problèmes suivants peuvent survenir :

La résolution native fournit les images les plus précises et les plus claires car chaque pixel de l'écran est rendu selon les données directement calculées par le GPU. Ceci est particulièrement important dans les applications professionnelles telles que la conception graphique, la production vidéo et le développement de jeux, où la précision des couleurs et les détails sont essentiels.

Il est important de bien différencier les performances obtenues par l’upscaling et les résultats obtenus par la résolution native. La mise à l'échelle, malgré sa capacité à améliorer les performances du matériel, introduit des compromis sur la qualité d'image qui ne doivent pas être confondus avec les performances de résolution native. La transparence dans l'affichage de ces différences est essentielle pour que les consommateurs puissent faire des choix éclairés entre les performances réelles et la qualité graphique.

En conclusion, même si les technologies de mise à l’échelle peuvent être utiles et importantes pour améliorer les performances dans certains scénarios, elles ne doivent pas être utilisées pour remplacer la résolution native, qui offre la meilleure qualité d’image. Les fabricants doivent s'efforcer de trouver un équilibre entre performances et qualité tout en s'efforçant d'améliorer les performances de résolution native de leurs cartes graphiques !